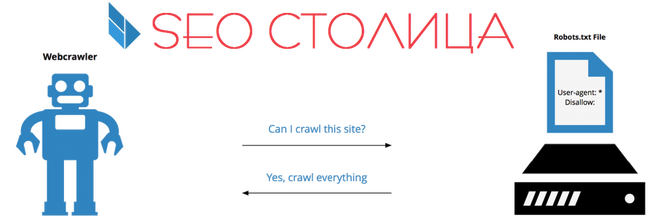

Robots.txt — это текстовый файл в стандартном формате «.txt», который находится в корневой директории сайта.

Что такое Файл Robots.txt?

Поисковые машины («робот», англ. crawler) изначально обращаются к файлу robots.txt. В нем хранится информация о страницах, которые необходимо скрыть от индексации роботом или наоборот обязательно учитывать при анализе документов сайта. Таким образом robots.txt — это инструкция для поискового робота по количеству страниц сайта, которые мы хотим видеть в выдаче и использовать в ранжировании (например страницы отвечающие за коммерческие факторы) и страниц, которые являются исключительно административными, техническими, дублями и т.д. и требуют скрытия.

Индексация и использование Robots.txt

Файл robots.txt начинает индексироваться в первую очередь, т.к. он по сути и задает дальнейший алгоритм следования робота по сайту, и именно для этого он и используется.

Директива HOST в Robots.txt

Директива HOST (команда) вставляется на последней строке в завершении файла и обозначает главное зеркало сайта, к которому необходимо обращаться поисковому роботу. Также в конце файла robots.txt размещается Sitemap (карта сайта).

Закрыть элементы сайта в Robots.txt

Для того, чтобы закрыть определенную страницу, документ или их часть, необходимо прописать в файле robots.txt директиву «Disallow» в формате:

Disallow: /

В таком формате Вы запретите к идексированию весь сайт. В случае необходимости закрыть отдельную страницу, после символа «/» необходимо указать требуемый Url-адрес.

Открыть элементы сайта в Robots.txt

Для того, чтобы открыть определенную страницу, документ или их часть, необходимо прописать в файле robots.txt директиву «Allow» в формате:

Allow: /

В таком формате Вы откроете к идексированию все страницы сайта. В случае необходимости открыть только отдельную страницу, после символа «/» необходимо указать требуемый Url-адрес.

Создать Robots.txt

- В стандартном текстовом редакторе (например «Блокнот» на OS Microsoft Windows) создайте файл с именем «robots.txt» и заполните его в соответствии с Вашими требованиями.

- Проверьте созданный файл на корректность в официальном сервисе «Яндекс.Вебмастер».

- Загрузите готовый файл «robots.txt» в корневую директорию сайта.

Настроить файл Robots.txt

Для того, чтобы корректно настроить файл «robots.txt» отдельно для каждой поисковой системы, необходимо задать следующие директивы:

User-agent: Yandex

User-agent: Googlebot

И укажите для каждой свои адреса или части документа на сайте.

Проверить Robots.txt

Для того, чтобы проверить корректность и работоспособность файла robots.txt используйте соответствующий раздел Вебмастера системы Яндекс.

Наши рекомендации

Внимательно изучите свой файл «robot.txt» т.к. ошибки в нем могут существенно ухудшить присутствие сайта в поиске или совсем исключить его. Если Вы новичок и не готовы вникать во все тонкости продвижения сайтов, то можете просто открыть роботам поисковых систем все страницы своего сайта с помощью данного шаблона:

User-agent: *

Allow: /

Host: https://вашсайт.ру

Sitemap: https://вашсайт.ру/sitemap.xml

*Вместо «вашсайт.ру» - вставьте адрес вашего сайта.

Для ускорения индексации файла sitemap воспользуйтесь приоритетным переобходом